ktransformers 框架

约 386 字大约 1 分钟

2025-02-20

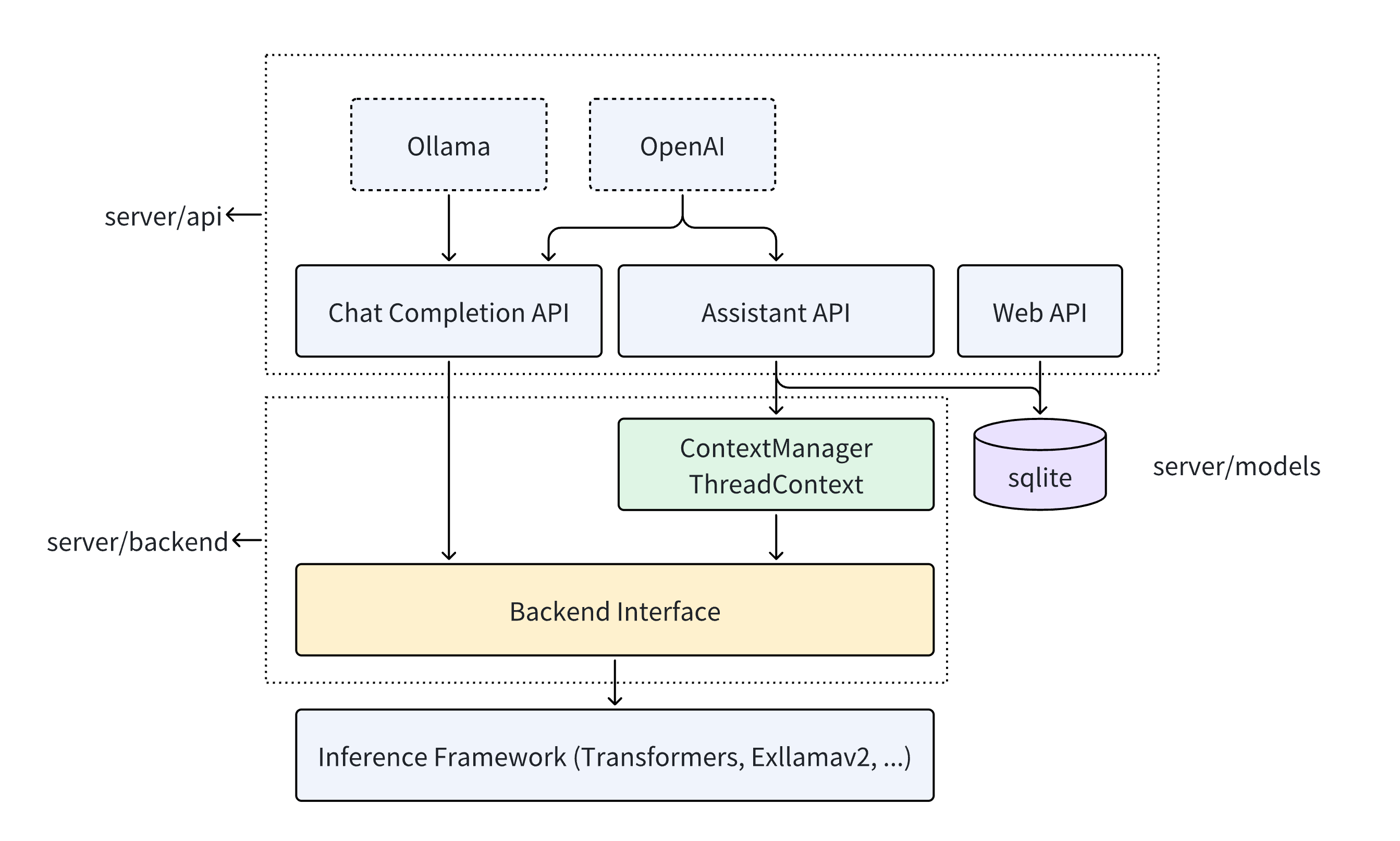

KTransformers(Quick Transformers)一款由清华大学 MADSys 和 Approaching.AI 专为优化大模型本地推理体验而设计的开源框架。旨在通过高级内核优化和布局/并行策略来增强您的 Transformer 体验。

KTransformers 是一个灵活的、以 Python 为中心的框架,其设计以可扩展性为核心。通过使用单行代码实现和注入优化的模块,用户可以访问与 Transformers 兼容的界面、符合 OpenAI 和 Ollama 的 RESTful API,甚至是简化的类似 ChatGPT 的 Web UI。

服务

KTransformers 专注于优化大模型的本地推理体验。它通过先进的内核优化和灵活的硬件配置策略,让开发者能够在有限的资源下实现高效的模型推理,并提供了与 Transformers 兼容的接口、符合 OpenAI 和 Ollama 标准的 RESTful API。

应用

本地运行 671B DeepSeek-Coder-V3/R1

本地运行 671B DeepSeek-Coder-V3/R1:仅使用 14GB VRAM 和 382GB DRAM 运行其 Q4_K_M 版本(教程)。

本地运行 236B DeepSeek-Coder-V2:仅使用 21GB VRAM 和 136GB DRAM 运行其 Q4_K_M 版本,可在本地台式机上实现,其得分甚至高于 GitHub Pages 中的 GPT4-0613。